日本語学習において、発音の習得は最も困難な課題の一つです。特に外国人学習者にとって、日本語特有の音韻体系や音調変化を正確に身につけることは容易ではありません。従来の学習方法では、教師による直接指導に依存することが多く、個別の発音練習機会が限られていました。

しかし、近年の音声認識AI技術の発達により、個人でも高精度な発音評価システムを構築できるようになりました。本記事では、音声認識APIを活用して日本語発音練習アプリを開発する具体的な手法を、実装例とともに詳しく解説します。

日本語発音練習アプリに適した音声認識APIを選定する際は、以下の要素を考慮する必要があります。まず、日本語の音韻認識精度が高いこと、リアルタイム処理に対応していること、そして発音評価に必要な詳細な音素情報を取得できることが重要です。

Google Speech-to-Text APIは、日本語の認識精度が高く、音素レベルの詳細情報も取得可能です。一方、Microsoft Azure Speech Servicesは、発音評価専用の機能を提供しており、特に教育アプリケーションに適しています。Amazon Transcribeは、コスト効率が良く、大量の音声データを処理する場合に有効です。

音声認識APIを選定する際は、レスポンス時間も重要な要素です。発音練習アプリでは、学習者がすぐにフィードバックを得られることが学習効果を高めます。理想的には、音声入力から結果表示まで2秒以内に完了することが望ましいでしょう。

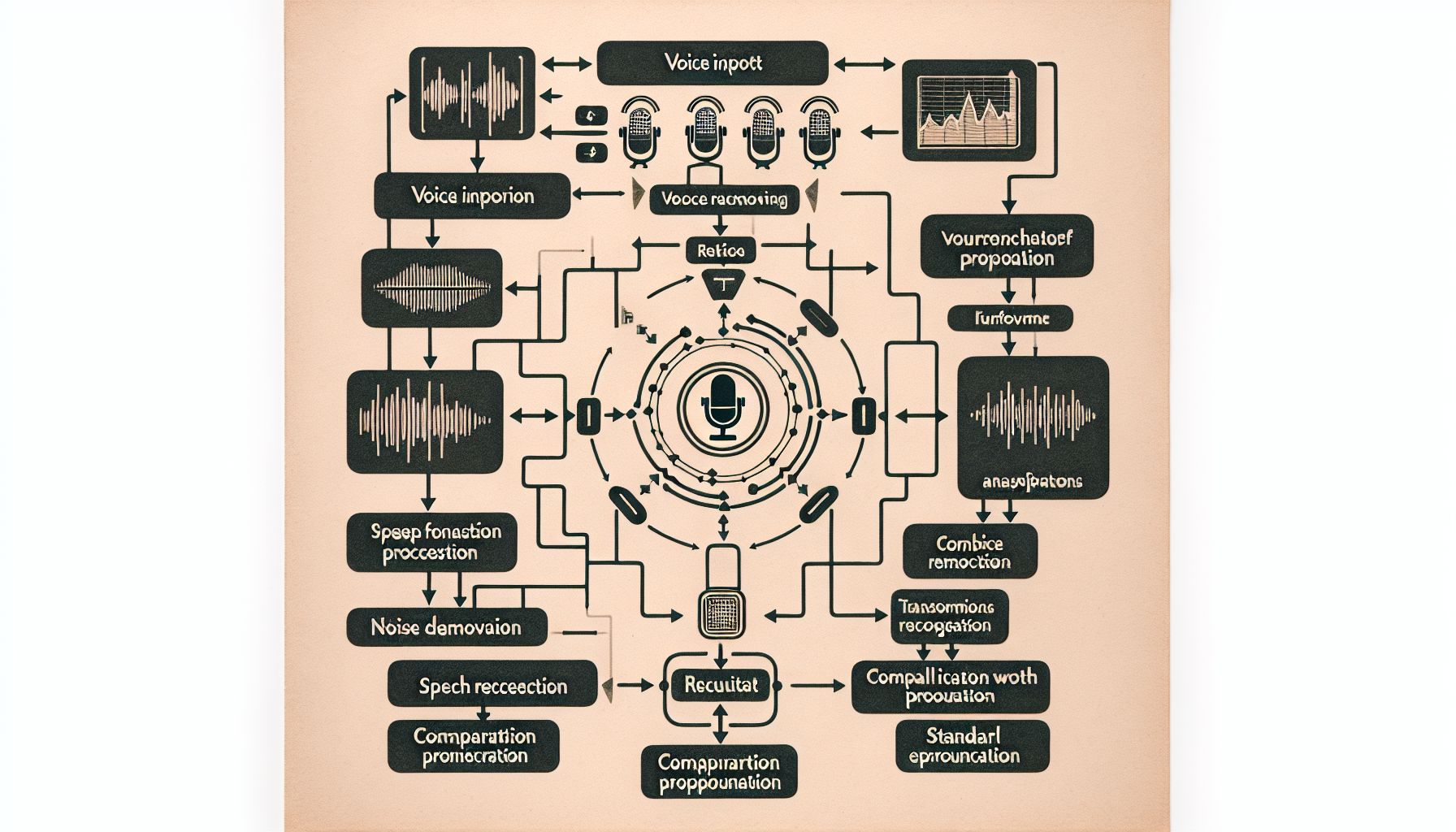

日本語の発音評価では、単純な音素の正確性だけでなく、モーラ(拍)の長さ、アクセントの位置、音調変化なども考慮する必要があります。例えば、「はし」という単語は、アクセントの位置によって「箸」「橋」「端」の意味が変わるため、音調パターンの評価が不可欠です。

評価アルゴリズムでは、まず音素レベルでの正確性を測定し、次にモーラ単位での時間的な適切性を評価します。さらに、文全体のアクセントパターンを分析し、自然な日本語の韻律に近いかどうかを判定します。

より高精度な評価を実現するため、機械学習モデルを組み込むことが効果的です。日本語ネイティブスピーカーの発音データを教師データとして使用し、学習者の発音との類似度を計算します。この際、Deep Learning技術を活用したスペクトログラム解析により、微細な音響特徴の違いも検出できます。

import librosa

import numpy as np

from sklearn.metrics.pairwise import cosine_similarity

def evaluate_pronunciation(user_audio, reference_audio):

# 音響特徴量の抽出

user_mfcc = librosa.feature.mfcc(user_audio, sr=22050, n_mfcc=13)

ref_mfcc = librosa.feature.mfcc(reference_audio, sr=22050, n_mfcc=13)

# 類似度計算

similarity = cosine_similarity(user_mfcc.T, ref_mfcc.T)

score = np.mean(similarity.diagonal())

return score * 100 # 0-100のスコアに変換

効果的な発音練習アプリには、学習者が直感的に理解できる視覚的フィードバックが不可欠です。音素ごとの正確性を色分けで表示したり、アクセントの高低を波形グラフで示したりすることで、学習者は自分の発音の問題点を具体的に把握できます。

特に日本語学習者にとって重要なのは、長音(ー)や促音(っ)、撥音(ん)の区別です。これらの特殊音素は、視覚的に強調表示することで、学習者の注意を引きつけ、正確な発音を促進できます。

リアルタイムで音声を可視化することで、学習者は発音中にも自分の声の特徴を確認できます。WebAudioAPIを活用して、ブラウザ上で音声波形やスペクトログラムをリアルタイム表示する実装例を以下に示します。

// WebAudioAPIを使用したリアルタイム音声可視化

class VoiceVisualizer {

constructor(canvasId) {

this.canvas = document.getElementById(canvasId);

this.ctx = this.canvas.getContext('2d');

this.audioContext = new AudioContext();

this.analyser = this.audioContext.createAnalyser();

this.dataArray = new Uint8Array(this.analyser.frequencyBinCount);

}

startVisualization() {

navigator.mediaDevices.getUserMedia({ audio: true })

.then(stream => {

const source = this.audioContext.createMediaStreamSource(stream);

source.connect(this.analyser);

this.draw();

});

}

draw() {

this.analyser.getByteFrequencyData(this.dataArray);

this.ctx.clearRect(0, 0, this.canvas.width, this.canvas.height);

// 音声波形の描画

const barWidth = this.canvas.width / this.dataArray.length;

for (let i = 0; i < this.dataArray.length; i++) {

const barHeight = this.dataArray[i] / 255 * this.canvas.height;

this.ctx.fillStyle = `hsl(${i * 2}, 100%, 50%)`;

this.ctx.fillRect(i * barWidth, this.canvas.height - barHeight, barWidth, barHeight);

}

requestAnimationFrame(() => this.draw());

}

}

学習者のレベルに応じた段階的なフィードバックシステムを構築することで、継続的な学習を促進できます。初級者には基本的な音素の正確性に焦点を当て、上級者にはより細かな音調変化や自然性の評価を提供します。

発音練習アプリのフロントエンド開発では、レスポンシブデザインとアクセシビリティを重視する必要があります。特に、マイクの使用許可やブラウザの音声認識機能への対応は、ユーザーエクスペリエンスに大きく影響します。

React.jsを使用した実装例では、useEffectフックを活用して音声認識の開始・停止を管理し、状態管理にはReduxやContext APIを使用して、録音状態や評価結果を適切に管理します。

音声データの処理には相当な計算リソースが必要となるため、バックエンドの設計では非同期処理とキューイングシステムの実装が重要です。Node.jsとExpress.jsを使用した場合、音声ファイルのアップロード、処理、結果の返却を効率的に管理できます。

// Express.jsを使用した音声処理エンドポイント

const express = require('express');

const multer = require('multer');

const { evaluatePronunciation } = require('./pronunciation-evaluator');

const app = express();

const upload = multer({ dest: 'uploads/' });

app.post('/evaluate-pronunciation', upload.single('audio'), async (req, res) => {

try {

const audioFile = req.file;

const referenceText = req.body.text;

// 音声認識と評価の実行

const result = await evaluatePronunciation(audioFile.path, referenceText);

res.json({

score: result.score,

feedback: result.feedback,

detailedAnalysis: result.analysis

});

} catch (error) {

res.status(500).json({ error: 'Processing failed' });

}

});

継続的な学習を促進するため、ゲーミフィケーション要素を取り入れることが効果的です。発音スコアに応じたポイント制度、連続学習日数の記録、レベルアップシステムなどを実装することで、学習者のモチベーションを維持できます。

特に日本語学習では、ひらがな、カタカナ、漢字の発音練習を段階的に進められるレベル設計が重要です。各レベルで達成すべき目標を明確にし、学習者が自分の進歩を実感できるようにします。

学習者同士の交流を促進するソーシャル機能を実装することで、学習の動機付けを強化できます。発音コンテストの開催、学習記録の共有、相互評価システムなどを通じて、コミュニティベースの学習環境を構築します。

音声認識AIを活用した日本語発音練習アプリの開発は、適切な技術選択と実装により、学習者に大きな価値を提供できます。音声認識APIの選定では、日本語特有の音韻体系に対応した高精度なサービスを選択し、発音評価アルゴリズムでは音素レベルからアクセントパターンまで包括的に評価することが重要です。

ユーザーフィードバックの実装では、視覚的な表現とリアルタイム処理により、学習者が直感的に理解できるインターフェースを構築しましょう。また、ゲーミフィケーション要素やソーシャル機能を組み込むことで、継続的な学習を促進できます。

今後のAI技術の発展により、さらに高精度で自然な発音評価が可能になることが期待されます。開発者の皆さんも、これらの技術を活用して、日本語学習者の発音習得を支援する革新的なアプリケーションを開発してみてください。

AIエンジニア/日本語教師